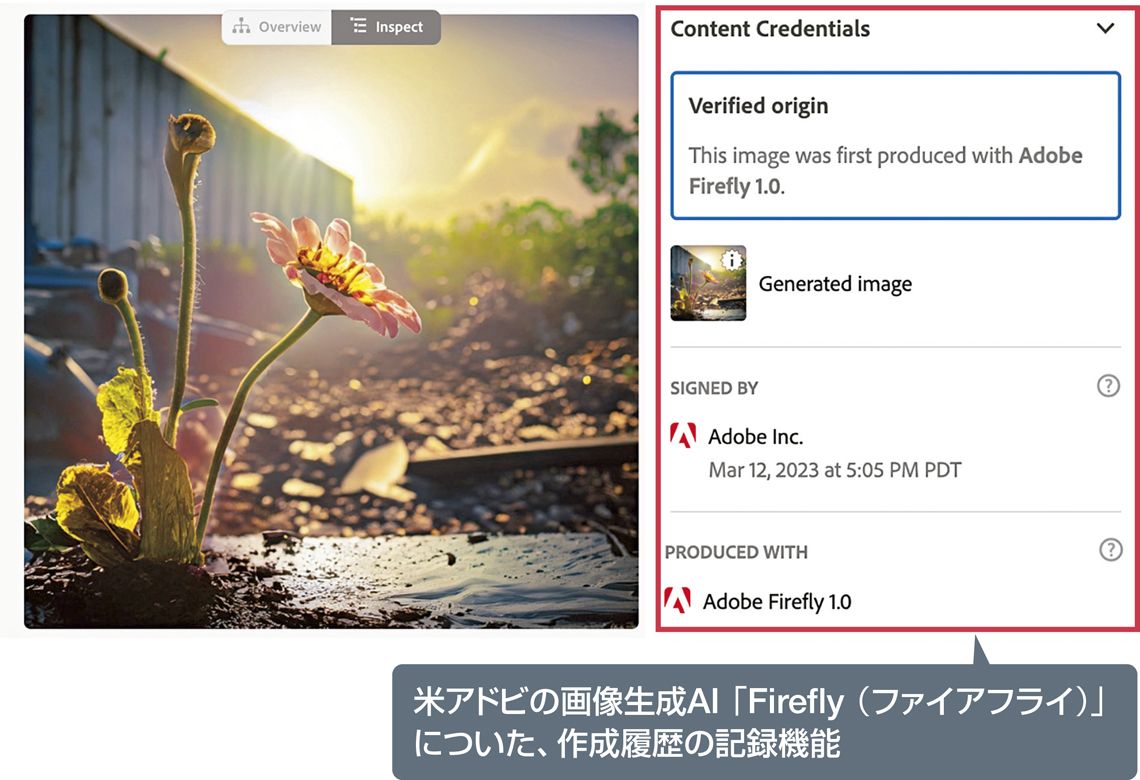

生成AIの普及で、ニセ情報が流布するリスクも爆発的に高まっている。

生成AIが爆発的に普及する中、社会にとって脅威となるのが信憑性の問題だ。例えばChatGPTなどのチャットボットでは、AIがもっともらしくウソをつく、「ハルシネーション(幻覚)」と呼ばれる現象の起こることが知られている。

東京大学は4月に発表した学生・教職員向けの利用指針で、「使いこなすには相当の専門的な知識が必要であり、回答を批判的に確認し、適宜修正することが必要」とした。今後、新しいモデル手法の開発などによって精度は改善されていくといわれているが、出力に対してのファクトチェックは今後も求められる。

巧妙な文章による詐欺にも注意が必要だ。7月に米ハーバード大学が発表した生成AIのガイドラインには、「はるかに大規模で精巧な詐欺を容易に作り出せるようになった」とあり、フィッシング詐欺への注意喚起を行っている。

![週刊東洋経済 2023年7/29特大号(ChatGPT超・仕事術革命)[雑誌]](https://m.media-amazon.com/images/I/51S8PogrJoL._SL500_.jpg)

無料会員登録はこちら

ログインはこちら