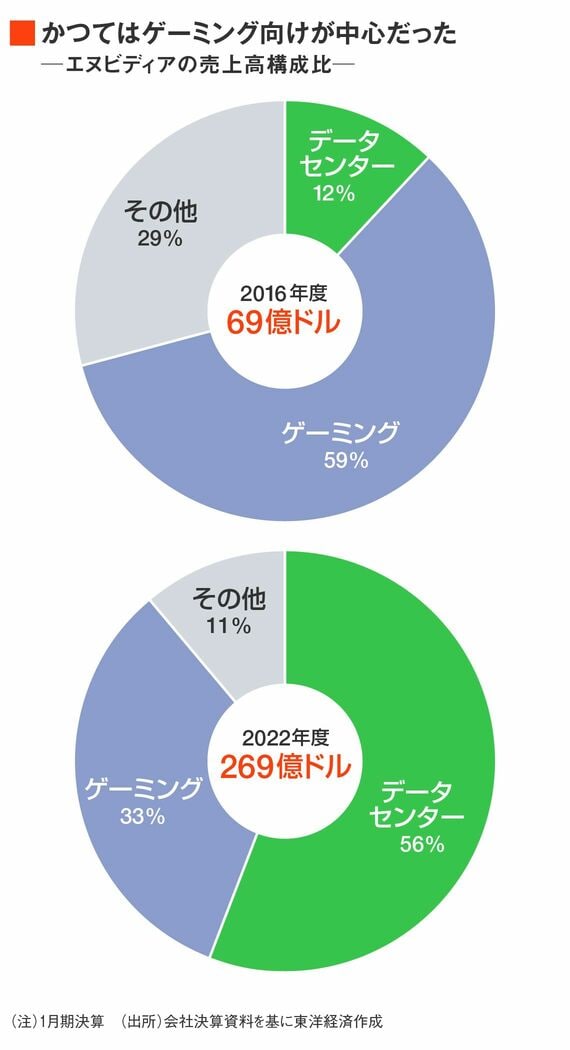

かつて売上高の過半を占めていたのはゲーミング向けだ。だが、市場は成熟しているうえ、浮き沈みが激しい。暗号資産のマイニング用途で顕著だったが、相場の上昇・下落によって需給バランスが崩れやすい。2023年1月期通期でみると、ゲーミング向けは過剰在庫を抱えたことで前期比27%の大幅減収となった。

一方で、データセンター向けはほぼ一貫して伸びている。背景にあるのは、ディープラーニングを使ったAIの普及だ。AIモデルを開発する際の「学習(トレーニング)」に、ゲーミングで技術を培った同社のGPUが適していたのだ。

元来、データセンターにはCPU(Central Processing Unit)のみ搭載するケースが一般的だった。だが、ディープラーニングの学習プロセスで大量の「データを食わせる」時には、より多くの計算が行えるGPUのほうが効率がいい。

CPUは少数の演算回路(コア)で複雑な計算を行うのが得意。言い換えると、限られた少数精鋭で複雑なタスクをこなしている。対するGPUは、多くのコアを使った「並列処理」に強い。大人数が一斉に比較的単純なタスクを処理するイメージだ。これにより3Dゲームなどで素早く切り替わる画面の描画を効率的に行える。

市場が何倍にも膨れ上がった

このような両者の特長を踏まえて、計算の司令塔となるCPUと併せて、有能な実行部隊としてGPUもデータセンターに搭載する流れが進んできた。

英調査会社のオムディアによれば、データセンターのAI向け半導体シェアはエヌビディアが8割超を占めている。エヌビディアとしてもこの領域に注力。2020年にはデータセンターに使われる設備やソフトウェアを扱うアメリカのメラノックス社を70億ドルで買収している。

だが、「データセンターの中でGPUが搭載されているものはまだ全体の1〜2割程度」(オムディアの杉山和弘氏)といわれる。普及が進んだとはいえ、AI処理は世界のデータ使用量全体にとってはわずかなものでしかない。

それが、生成AIの普及によって事情が変わる。

画像生成や自然言語生成などの生成AIでは、学習によって作り上げたAIモデルを動かして結論を得る「推論」というプロセスが必要になる。ChatGPTに質問をした際、答えが返ってくるのは「推論」の結果だ。

無料会員登録はこちら

ログインはこちら