そこでSさんが、ChatGPTに、

「出願したい特許と似たものが、すでに存在するか」

と質問をしたところ、実在しない事例を挙げて、「もっともらしく」返してきたといいます。いわば「ケースをでっち上げる」わけですね。アメリカと日本の法律を混同したり、商標法と著作権法を混同したりすることもあるということでした。

ここで問題となるのは、生成AIの返事の「もっともらしさ」です。先ほどの事故の事例の「言い切った者勝ち」のような現象が、ここでも起こり始めています。

ChatGPTは責任を負ってくれない

ただし、ChatGPTは、自身が生成した文章について、責任を負ってはくれません。それっぽい回答を信じてしまった人が責任を負うことになります。

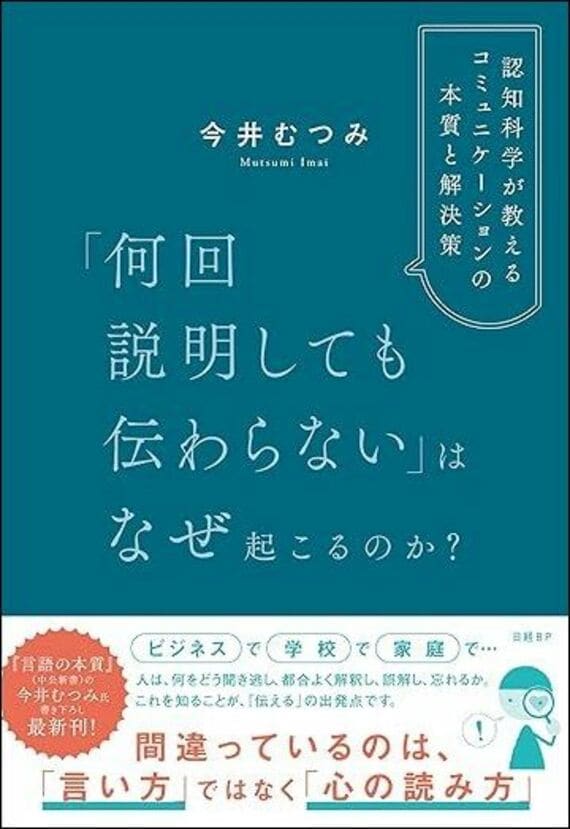

こうしたことが起こりがちということもあり、また剽窃(ひょうせつ)などの問題と関連することもあり、企業でも学校でも、生成AIが出力したものをそのまま使用することは禁止されています。

でも例えば、まだ何が正しくて、何が正しくないかの判断がつかない子どもがChatGPTの答えを信じてしまい、取り返しのつかない誤りを犯してしまったときは、どうなるでしょうか。あるいは、その子どもから話を聞いた親が、信じてしまったら?

さらに恐ろしいのは、使用したときは「ChatGPTの間違った情報だ」と理解していても、後に似た情報に触れた際に、「この話はどこかで聞いたことがある」と偽情報の中身だけを想起してしまうケースも考えられることです。

誰しもに起こり得るこうした事態について、「思い込むほうが悪い」と言えるでしょうか。

記事をマイページに保存

できます。

無料会員登録はこちら

ログインはこちら

印刷ページの表示はログインが必要です。

無料会員登録はこちら

ログインはこちら

無料会員登録はこちら

ログインはこちら