普通のメガネで翻訳・ナビ、AIと会話しながら検索できるように。Google I/O 2025で発表された未来の日常生活

Android XRは、1つのプラットフォームで複数の機器を開発できる。Project MoohanのようなApple Vision Pro対抗といえる製品を作ることもできれば、基調講演で発表されたスマートグラスのように、スマホ連携を前提として「情報を見る」ような機器を作ることもできる。

Geminiが組み込まれ、自然な言葉で「会話」

GoogleはAndroid XRを「Gemini登場以降に提案される初めてのプラットフォーム」と位置付けている。それはどういうことかといえば、ユーザーインターフェースにGeminiが深く組み込まれているためだ。

Android XR対応機器では、Geminiによる音声対話が組み込まれている。単に声で命令をするのではなく、人間と話すように、自然な言葉で「会話」しつつ、必要なことを質問したり、アプリを操作してもらったりできる。

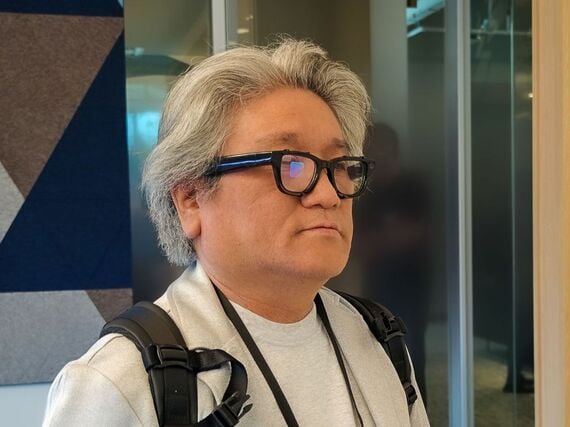

筆者が体験したデモでは、目の前に置かれた絵を認識し、その作者を教えてくれる……というものがあった。AIが目の前にあるものがなにかを教えてくれる、というデモはよくあるものなのだが、今回の場合には対話する相手がGeminiなので、「使われている技法は」「この絵が描かれた時代の特徴は」といったように、会話をそのまま続けていくこともできた。

GoogleはAndroid XRで「Understands your Context(あなたの文脈を理解)」というキャッチフレーズを使っている。Geminiの画像認識で周囲にあるものや文章を理解し、生活の中で必要な情報を提供する……ということなのだ。冒頭で出てきた自動翻訳はその一例であり、Geminiを生かした新しいデバイスを作ることが狙いでもあるわけだ。

Google I/Oが開催されている最中である5月21日、OpenAIは、元アップルのジョニー・アイブ氏による企業ioを合併した。狙いは新しいハードウエアの開発であり、成果は「来年(2026年)に公表される」(OpenAI)としている。

無料会員登録はこちら

ログインはこちら