普通のメガネで翻訳・ナビ、AIと会話しながら検索できるように。Google I/O 2025で発表された未来の日常生活

Googleは現在、同社のAIサービス「Gemini」の活用に全力を投じている。5月20日に開催された同社の年次イベント「Google I/O 2025」では、デジタルガジェットから検索サービスまで、Geminiの活用が軸になって構築されていた。

結果としてそのことは「これまでに培ったGoogleの強みを最大限に活用する」という戦略であり、他のAIプラットフォーマーとの差別化という話にもなる。

それはどういうことかを解説してみたい。

Android XRで「AI連動デバイス」を開発

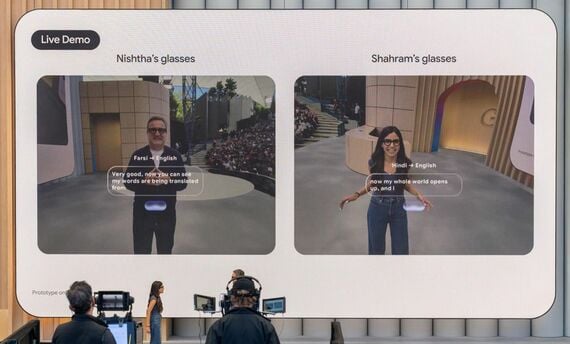

Google I/Oの発表の中でも、見た目に最も派手だったのは、新しいスマートグラスのデモだっただろう。一見普通のメガネにしか見えないものがワイヤレスでスマートフォンとつながり、AIを介して自動翻訳やナビゲーションを提供する。

このスマートグラスの開発に使われているのが「Android XR」というプラットフォームだ。これはGoogleがVRやARを活用するデバイス向けに作った新プラットフォームで、海外ではハイエンドデバイス「Project Moohan(仮称)」から年内に発売される。

無料会員登録はこちら

ログインはこちら