無知ではすまない「日本のAI活用」に欠けた視点 リクナビ事件で露呈した個人情報保護法の課題

第4に、個人データの取り扱いに関する責任の所在です。リクナビ事件では、リクルートキャリアと契約企業との業務委託契約に基づき、前者から後者に内定辞退率スコアが販売されました。この関係が「委託」で済まされるかという問題があります。すなわち、個人データの委託は、個人データの入力(本人からの取得を含む)、編集、分析、出力などの処理といった、独自のデータ処理の利用目的を有しない業務をいうものとされます。

GDPRでは、複数のアクターが個人データの処理をそれぞれの目的で利用する場合、共同管理者として関連するすべての管理者が責任を分担することになります。個人データの処理についての責任が不明瞭であることは、個人の権利利益の保護という意識が欠落する原因となってしまいます。

最後に、制裁についてです。リクナビ事件では、内定辞退率スコアを1社あたりに400万円から500万円で販売していましたが、これに対する制裁金が科されることはありませんでした。個人情報保護委員会による勧告と指導にとどまり、GDPRで認められているような高額な制裁金(年間総売り上げの4%または2000万ユーロのいずれか高額なほう)は日本法にはありません。

EUは人間中心のアプローチを提唱

リクナビ事件についてみると、これらがいずれも未解決のまま、個人データが共有されていたことがわかります。今後、AIの技術を用いたデータ利活用を推進するうえで、少なくとも前記に掲げた点について個人情報保護法制による手当てをしていくことが求められます。

個人情報保護法で個人の権利利益を万全に保護できているからこそ、本人の合理的期待に反したデータの取り扱いが行われないという信頼感を生み出し、データ利活用への安心が担保されるのです。

この点、注目するべきはEUのAI規制論です。欧州委員会専門家会合が2018年4月に倫理ガイドライン、そして、欧州委員会が2020年2月にAI白書を公表しています。

その中で、「ヨーロッパのAIは人間の尊厳やプライバシー保護といった我々の価値と基本権に基づくものであること」が出発点として明確にされています。人間が主であり、データが従であるという人間とデータとの主従関係が明確にされており、人間をデータの商品化とすることへの抵抗から人間中心のアプローチが提唱されました。

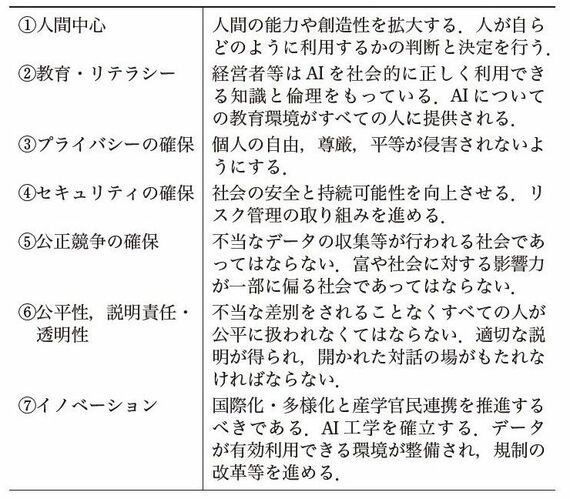

日本の内閣府が示した「人間中心のAI社会原則」は、EUの「人工知能に関する倫理ガイドライン」や「AI白書」における人間中心の原則と軌を一にしているとみることができます。

無料会員登録はこちら

ログインはこちら