iPhoneで撮影した画像からChatGPTやGoogle検索を行えるVisual Intelligenceが便利。非対応モデルも工夫すれば同様のことが可能

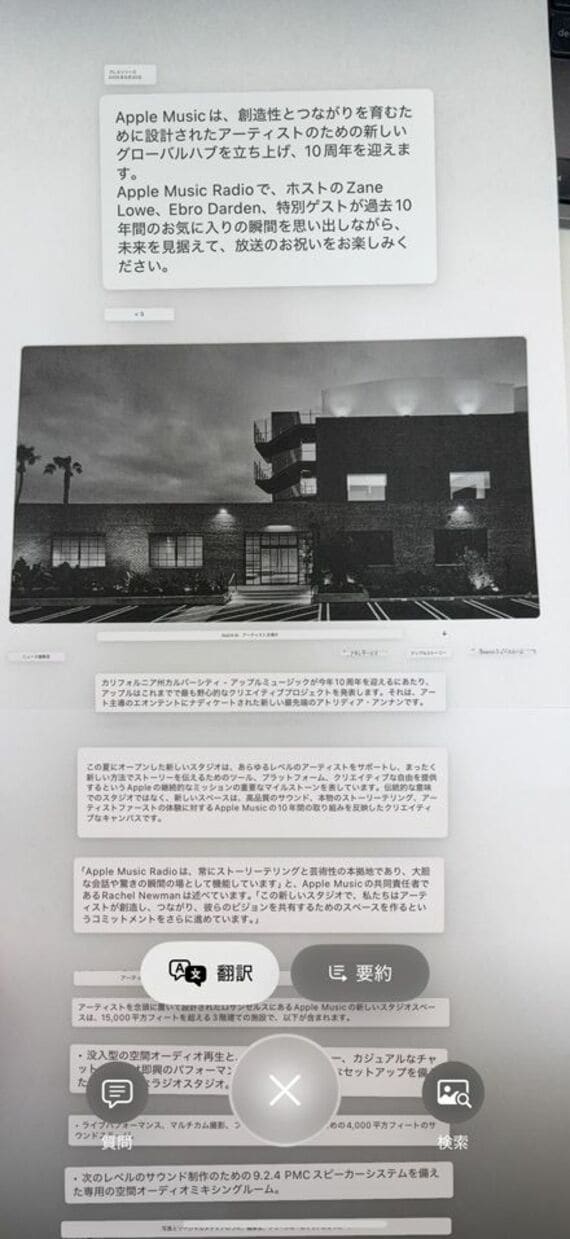

ただし、質問と検索だけがVisual Intelligenceの用途ではない。例えば、外国語で書かれたサイトや紙を中央のシャッターで写すと、それが外国語であることを自動で認識して、「翻訳」というボタンが表示される。

タップすると、画面内に映し出された外国語が、一瞬で日本語になる。文章が長いと、「要約」というボタンが表示されることもある。

また、イベントのチラシを写したところ、住所やカレンダーのアイコンが表示された。住所をタップすると「マップ」アプリが立ち上がり、経路を検索できる。「カレンダー」を押すと、スケジュールとしてそれを登録することが可能になる。

さらには、チラシ内に電話番号があったり、メールアドレスが書かれていたりすると、対応するアプリを呼び出すことも可能。質問や検索だけでなく、さまざまなアプリの起点にもなる。

目の前にあるものを認識させたいときに、まず呼び出したい機能と言えるだろう。

カメラコントロールがないiPhoneでも使える

便利なVisual Intelligenceだが、iPhone 15 Pro/15 Pro MaxやiPhone 16eにはカメラコントロールがないため、そもそもこれが搭載されていることに気づいていない人もいるだろう。とは言え、Visual Intelligenceも立派なApple Intelligenceの機能の1つ。これ自体は、iPhone 15 Pro/15 Pro MaxやiPhone 16eにも対応しているため、一工夫すれば利用が可能だ。

これら3機種でVisual Intelligenceを呼び出す方法は、3通りある。1つが、左側面に搭載されている「アクションボタン」に割り当てること。

「設定」の「アクションボタン」に進み、左右にスワイプしていくとVisual Intelligenceを割り当てることが可能になる。カメラコントロールと比べると位置が上にあり、片手持ちだとやや指が届きづらいが、ハードウェアキーですぐに呼び出せるのは便利だ。

無料会員登録はこちら

ログインはこちら