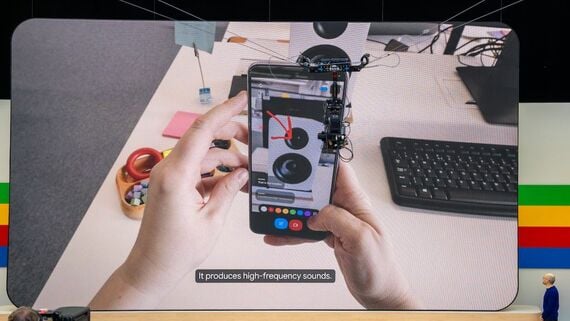

Google I/Oの会場には限定的なものながら、デモを体験できる機会も用意されていた。筆者も体験してみたが、非常に印象的なものだった。

画面に線で絵を描き、「これはランドマークの1つ」とヒントを与えると、Astraは「ゴールデンゲートブリッジですね」と答える。

最初に黄色いバスのおもちゃを見せて「これはジョージという名前」と伝え、その後にいくつか別のおもちゃを見せつつ名前をつけたあと、「ジョージの色は?」と聞くと「黄色ですね」と答えてくる。

回答はスムーズで、人間との対話にかなり近い。知識を蓄えた生成AIや検索エンジンとも異なり、より人間のように多様な情報を使い、人間のような対話を実現するもの……という印象だ。

チャットボットから「マルチモーダル」へ

現在の生成AIは、命令を文章として与えて回答が文章で返ってくる「チャットボット型」のサービスが主流だ。しかし、それだけが生成AIの使い方というわけではない。

GoogleがProject Astraで目指すのは「将来のAIエージェント」だ。AIエージェントとは、人と対話しつつ人をサポートするソフトウェアのことだ。GoogleのAI開発部門「Google DeepMind」は、現在Googleが使っている生成AI技術である「Gemini」を応用しつつ、さらに新しい技術を組み込んで開発を進めている。

AIエージェントでは単に命令を音声で伝えるだけでなく、コミュニケーションが主体になって課題を解決することが重要になる。人間が目や耳から情報を得て、それを対話のために活用するのと同じように、AIエージェントも複数の情報を活用するのが望ましい。

こうした要素を俗に「マルチモーダル」と呼ぶ。GoogleはGeminiを「マルチモーダルが得意なAI」とアピールしてきた。Project Astraはその先にあるものだが、他にも広く活用している。

例えば、動画を撮影しながらそこに映っているものについて質問する「Ask with Video」や、写真を保存するサービスである「Googleフォト」の中から、文章で示したシチュエーションにあった写真を探し出す「Ask Photos」などの新機能がそれにあたる。

マルチモーダル性を備え、音声で対話する生成AIを持っているのはGoogleだけではない。

冒頭で述べたように、Google I/O開催の前日には、OpenAIが「GPT-4o」を発表している。こちらもマルチモーダル性の強化が特徴だ。そして、Project Astraと同じように、人間と話しているような対話を実現している。

OpenAIが狙っているのも、Googleと同様に「人と対話しながら使うサービス」だ。OpenAIが究極的に目指しているのは「汎用人工知能(Artificial General Intelligence、AGI)。AGIが実現されていくなら、人間をサポートするAIエージェントに使われるのは必然である。

AIが人と対話するには、マルチモーダル性とともに「即応性」も必須になる。質問への回答に何秒もかかるようでは会話にならないからだ。

無料会員登録はこちら

ログインはこちら