コンピュータがこの10年で迎える限界の正体 AIは賢いが任せすぎると大事故も起こりうる

現在、急速に商用化が進むAI(人工知能)は、GPUというプロセッサ(半導体)を搭載したコンピュータで、大量のデータを処理することで動いている。GPUは元々、ゲームのコンピュータ・グラフィックスなどを処理する画像処理用半導体で、これがAIなどのコンピュータ・システムに搭載されるようになったのはこの10年のこと。そしてこのGPUコンピューティング(GPGPU)の本格運用に世界で初めて成功したのは、実は日本のコンピュータ研究者だ。

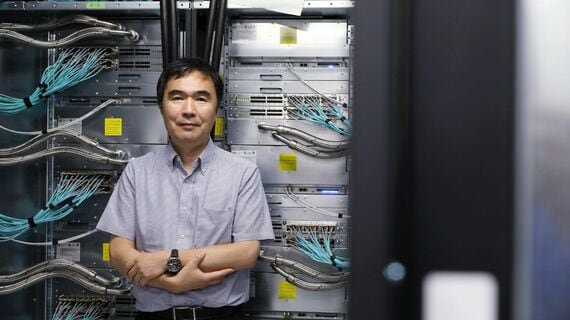

『週刊東洋経済』8月21日発売号「教養としてのテクノロジー」に連動したテクノロジー(テック)賢人へのインタビュー3回目は、GPGPUの始祖である松岡聡・東京工業大学学術国際情報センター教授。コンピュータの未来を聞いた。

「ムーアの後をどうするんだ?」

――コンピュータ研究において、今もっともホットな論点は何ですか?

今のコンピュータというものが、あと10年で限界が来るということです。

――もうすぐじゃないですか。

2020年代後半からやばくなります。前提にあるのは、これまでコンピュータを支えてきた2つのルールの終焉です。ひとつはデナード則。トランジスタは小型化するほど、高速かつ省電力になるというものですが、ある時期から小型化しても性能を上げられなくなった。そこで起こったのが、プロセッサのコア(演算処理を行う中核部分)を複数にして並列で計算するというやり方です。ところが今、もうひとつのルール・ムーア則も限界を迎え、いよいよ壁に直面しようとしています。

――半導体の集積密度が18~24カ月で倍になるという、いわゆるムーアの法則ですね。

そう。集積密度を上げるには回路線幅を狭くするのですが、これ以上狭くできないという事態がこれから10年で確実に起こります。このままでは、コンピュータの進化が止まる。だから研究者が今、いちばん関心があるのは、「ムーアの後をどうするんだ?」ということ。僕もこの3年ぐらい、ずっとこれを考えています。理論ではなくて、実際に何かに使えるコンピュータ・システムを作るには、最低でも10年かかるわけですから、今から考えないと間に合わない。ただこれから起こる変化があまりにも大きいから、なかなか世の中の意見がまとまらない。

無料会員登録はこちら

ログインはこちら