あなたはAIが診断する病院にかかりたいですか 人間の安全を脅かすリスクも存在している

人工知能が個人情報を駆使して医療に関わるようになると、どのようなリスクがあるのか、それに対してどのような配慮が必要なのか。

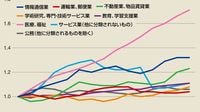

人工知能が発達し続けると、予想されるリスクとして、よくいわれるのは、いまは人間がやっているいろいろな作業を、人工知能がずっと上手にこなすようになって、人間から職を奪うのではないか、という危惧だ。

さらに、高度に自律した情報処理と判断決定の能力を人工知能に与えると、人間が守りたい権利や尊厳に反する、人間が持つ価値観とは異なる判断が重なって、結果として人間の安全・安心を脅かすようになるのではないかとの危惧もある。

偏った価値観が反映される恐れもある

そこで、人工知能が人間の安全と権利や尊厳を侵す決定をしないように、設計段階から人間の価値観を学習させて運用することが求められている。その際に大きな問題になるのが、「アルゴリズムのバイアス」である。人工知能に学習させるプロセスに、それを設計する研究者・技術者あるいは社会全般が持っている、特定集団などへの偏見を含む偏った価値観が反映されると、その学習から導き出される判断や決定に悪影響を与えることになる。

医療の分野でいえば、たとえば、認知症を伴う後期高齢者や障害者、外国人などを対象にした診療の困難さばかり強調したデータを学習させると、そうした特定のグループに対し必要な医療を行う判断が導かれなくなる恐れがある。偏りのない学習をさせ、そうした事態が起こる可能性を防ぐことを、人工知能を開発する研究者・技術者は求められている。

だが、そのようにして人間の価値観を備えた人工知能がつくれたとしても、そもそも人工知能にそうした価値判断をさせてよいのか、という問題は残る。これは医療などの現場で、人工知能を何らかの決定に用いる際の、責任のあり方につながる課題である。

無料会員登録はこちら

ログインはこちら