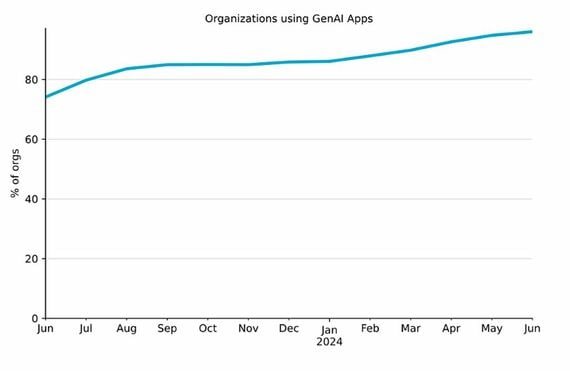

企業が生成AIを使う時に気をつけたい3つのこと 万全な管理のコツは、ユーザーとIT部門の連携

同じ調査では、生成AIアプリケーションに独自のソースコードを共有してしまったという内容の事案が、あらゆるデータポリシー違反の46%を占めていることがわかっている。こうした状況を放置すれば、場合によって企業は巨額の損失を被る可能性があるため、生成AIに関するデータ管理には万全の体制で臨む必要がある。

具体的に企業はどんなことに取り組むべきなのか。生成AIを使う時に気をつけたい3つのポイントを解説し、それぞれの問題にどう対処するべきかを、ユーザー側と管理側であるIT部門の2つの立場から考えてみよう。

ポイント①機密情報の流出に注意する

サムスン電子は2023年3月30日、ChatGPT経由で社内の機密情報が少なくとも3件流出したことを公表した。うち1件は、歩留まりや不良設備などを確認するためのプログラムに関連したソースコードをChatGPTに入力し、ソースコードの改善を試みた時に発生した。もう1件は、社内会議の録音データを文書ファイルに変換し、ChatGPTに入力して議事録を作成した際に起きた。生成AIの中核である大規模言語モデル(LLM)は常に「学習」しているため、プロンプトに入力した機密情報も、学習の対象になってしまう。

このように生成AIは、制御しながら使わないと、自社の機密情報や個人情報をばらまく媒体となり得る。もし、ライバル企業との差別化に関する情報が漏れれば、将来にわたって競争優位性を失うかもしれない。あるいは、生成AIを用いて営業資料を作成する際に、顧客の情報を誤って入力してしまい、それが漏洩すれば、法的な事態に発展してしまう。企業が社員に生成AIの利用を許可することには、メリットとデメリットの両面があることに留意しておきたい。

【ユーザー側の対策】ユーザーは生成AIに入力する情報をあらかじめ精査し、機密情報があればそれを匿名化するなどの処理が求められる。万が一、生成AIプラットフォームに学習されてしまっても、個別の内容を特定できないようにしておく必要がある。

【IT部門の対策】今回の事案でサムスン電子は緊急措置としてChatGPTへの1質問あたりのアップロード容量を1024バイトに制限した。一度に大量のデータが漏洩するのを防ぐために、これは一定の効果があると考えられる。改善が見られなければChatGPTへの接続を遮断する考えだという。一般的な対策として、ChatGPTなど生成AIのプロンプト入力履歴を高度な「DLP (Data Loss Prevention、データ損失防止)」ツールを通じて管理することが推奨される。ユーザーが生成AIに入力している情報を入力と同時に徹底的にチェックすることで、情報漏洩が発生した場合にそれを察知し、事前にブロックすることができる。また、高度なDLPツールは、データの流れを監視し不正なデータの移動を防止するだけでなく、機密情報のアップロードを検出し、自動的にブロックする機能も備えている。

無料会員登録はこちら

ログインはこちら